サマリ

本記事ではAIシステムのリスクやリスクの管理策のナレッジがつまったNISTのAI Risk Management Frameworkについて日本語でまとめました。

はじめに

NISTが発行するドキュメントではサイバーセキュリティフレームワーク(CSF)が非常に有名ですが、1年以上の時間をかけて整備されたAIに特化したリスクマネジメントフレームワークが2023年1月にリリースされています。まずは日本語で概要を把握したいということであれば、PwCさんが出しているこちらの記事が非常に有益です。ですが、当ブログでは管理人自身が内容を深く理解したいということ、また2024年3月時点でIPAさんなどから全文翻訳が出ていないこともあり、一つでも多く日本語での解説があったほうが有益であろうとの思いから「日本語まとめ」を執筆しています。執筆時点では生成AIが一世を風靡していますが、本AI RMFは生成AIだけではなく、AIシステム全般を対象としたものとなっています。

原文はNISTのこちらのページ内にある「AI Risk Management Framework (AI RMF 1.0)」というリンクをクリックすると閲覧できます。

全体感

AIリスクマネジメントフレームワーク(以下AI RMF)は全体で2部構成になっています。Part1では基礎情報として、「AIのリスクマネジメントにおける課題」や「信頼できるAIシステムの特徴」、「AIのライフサイクルと各ライフサイクルにおけるAIアクターの関わり」について書かれています。後半のPart2ではフレームワークメインパートであり、リスクマネジメントの対応策が4つのコア(Govern、Map、Measure、Manage)として整理されています。

Part1 基礎情報

1.1 リスクの構成

AI RMFの文脈では「リスク」とは事象が発生する確率と事象がもたらす影響の大きさや程度を総合的に測定したものを指しています。リスクと聞くとマイナスの印象を持たれる場合が多いと思いますが、ISO31000:2018では、影響とはプラスやマイナスのもの、あるいはその両方であり、機会あるいは脅威をもたらすと考えます。またリスク管理とはリスクに関して組織を統制するための協調的な活動のことを指しています。リスク管理プロセスでは一般的にマイナスの影響に対して対処しますが、AI RMFではAIシステムの予想されるマイナスの影響を最小限に抑え、プラスの影響を最大化する機会を特定するアプローチを提供する、と述べられています。

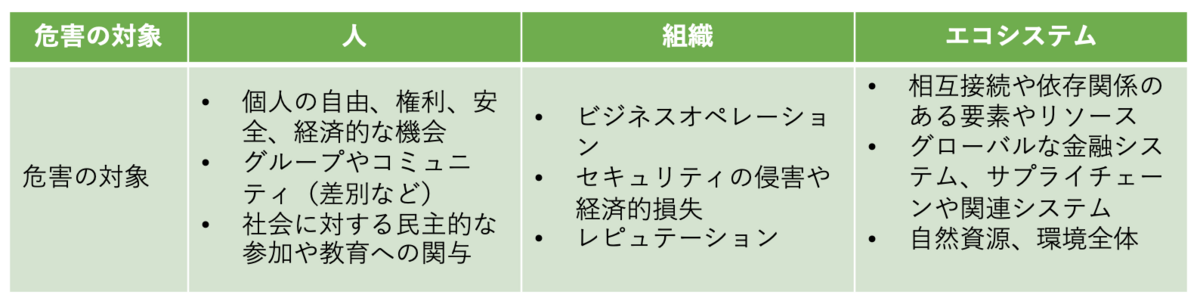

AIシステムに関連する潜在的な危害の例として、次の3点が例示されています。

1.2. AI特有のリスク管理の課題

ここではAI特有のリスク管理の課題について述べられています。

リスクの測定

- リスクは第三者のデータやソフトウェアから発生するだけでなく、利用方法からも発生する

- リスクや信頼性の測定方法が未成熟である

- AIのライフサイクルの異なる段階ではリスクの測定結果が異なる可能性がある

- 検証環境と運用環境ではリスクが異なる可能性がある

- 不透明なAIシステムではそもそもリスクの測定が困難である

- 人間を代替、補助するようなAIシステムにおいては、比較のための人間のベースラインが必要であるが、体系化することが難しい

リスクの優先順位付け

- リスクを完全に排除することは現実的ではなく、無駄なリソースの配分に繋がる可能性がある

- AIシステムごとにリスク評価を行い、リスクレベルと影響に基づいてリソース配分の優先順位付けをするリスク管理文化が重要である

- 最もリスクが高いシステムを最優先で管理する

- 人間と直接対話するAIシステムは、人間と対話しないシステムよりも優先度が高い場合がある

- 残存リスクを文書化し、エンドユーザーへの影響を考慮、管理する必要がある

組織的な統合とリスクの管理

AI RFMはAIリスクを個別に考えるべきではないとしています。AIアクターはライフサイクルにおける役割に応じて異なる責任と認識を持つからです(AI アクターは、経済協力開発機構(OECD)によって「AIを導入または運用する組織や個人を含め、AI システムのライフサイクルにおいて積極的な役割を果たす人々」と定義されています)。例えばAIシステムを開発する組織は、そのシステムがどのように使用されるかわからないかもしれません。このためAIのリスク管理は、より広範な企業のリスク管理の戦略やプロセスに統合されるべきだと述べられています。

- サイバーセキュリティやプライバシーなど、他の重要なリスクとともに扱う

- AI固有のリスクに加え、ソフトウェア開発や運用に共通のリスクも考慮する

- 組織は適切な説明責任、役割、文化、インセンティブ構造を確立し維持する必要がある

2. 関係者

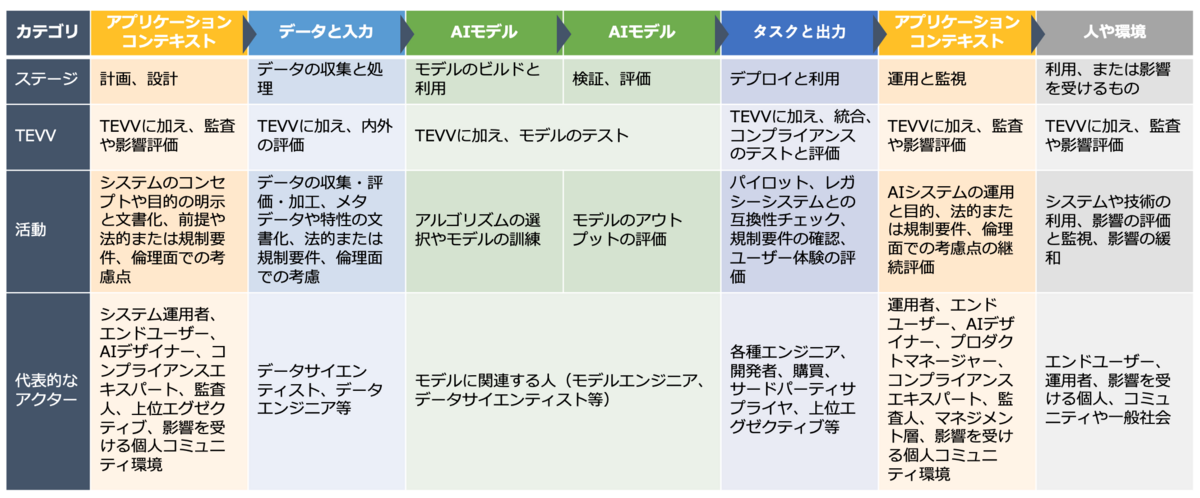

AIのリスクと潜在的な影響を特定し管理するためには、AIのライフサイクル全体に渡る様々な視点と関係者を考慮する必要があると述べられています。

TEVV:test, evaluation, verification and validation

3. AIリスクと信頼性

AI システムが信頼されるためには、利害関係者が重要視する様々な基準を満たす必要があるとしています。このAI RMFでは、信頼できる AI の特性を以下のように示し、それらへの対応方法をガイドしています。

- 信頼できるAIの特性:正確性と信頼性、安全性、セキュリティと耐障害性、説明責任と透明性、説明可能性と解釈可能性、プライバシー保護、公平性と有害バイアスの管理

- 信頼できるAIの構築は、これらの特性間のバランスを取ることが必要です。 全ての特性が社会技術的システム属性ですが、説明責任と透明性はAIシステム内部のプロセスや活動、および外部環境にも関連します。

- AIの信頼性はトレードオフが伴い、全ての特性が全ての状況に当てはまるわけではありません。 特定の状況においては、例えば、解釈可能性を最適化することとプライバシー保護との間でトレードオフが生じる可能性があります。

- AIリスクを管理する際、組織はこれらの特性間のバランスを取るという難しい決断に直面する可能性があります。 コンテキストを考慮した分析を行うことで、トレードオフの存在や程度を明らかにすることができますが、その解決方法については示唆されません。 解決方法は、関連するコンテキストにおける価値観に依存しており、透明性をもって正当化できる方法で解決する必要があります。

- AIのライフサイクル全体を通してコンテキストに対する理解を深めるためのアプローチがいくつかあります。 例えば、ドメイン専門家はTEVV(Testing and Evaluation of Values and Biases)の結果の評価を支援し、製品開発チームと導入チームがTEVVのパラメータを要件や導入条件に合わせるように連携することができます。 関係者やAI関係者からの幅広く多様な意見を取り入れることで、コンテキストに敏感な評価を行い、AIシステムのメリットとポジティブな影響を特定する機会を高めることができます。

- AIシステムの信頼性は、AIライフサイクルにおける各関係者の役割によって異なります。 同じ AI システムでも、設計者や開発者と導入者では、重要視する特性が異なる可能性があります。

信頼性の特性は相互に影響し合い、非常に安全だが不公平なシステム、正確だが不透明で解釈不能なシステム、不正確だが安全でプライバシー保護されており透明なシステムなどは望ましくありません。 リスク管理への包括的なアプローチは、信頼性の特性間のトレードオフのバランスを取ることが求められるとしています。 AI技術が特定のコンテキストや目的において適切なツールであるかどうか、そして責任を持って使用する方法を判断するのは、全てのAI関係者の共同責任であると説明されています。

一旦ここで区切って、次回続きからまとめていきます。